人工智能聊天机器人无疑是强大且有用的工具。然而,区分人类生成的内容和人工智能生成的内容的能力正在成为一个突出的问题。

为了解决这个问题,出现了 ZeroGPT 等工具。这些旨在区分人工智能和人类生成的内容。但它们有效吗?

让我们仔细看看人工智能检测工具,看看它们是否能够区分人类和人工智能生成的文本。

测试人工智能检测工具

他们说布丁的好坏在于吃的过程中。因此,让我们尝试一些测试,看看这些工具的效果如何。测试所有工具是不可能的,因此我们正在测试最流行的工具之一 - ZeroGPT。

对于材料,我们认为让 ChatGPT 尝试为本文编写介绍,然后将其与“人类生成的”介绍进行比较会非常有趣:

测试一:比较人类和人工智能生成的文章简介

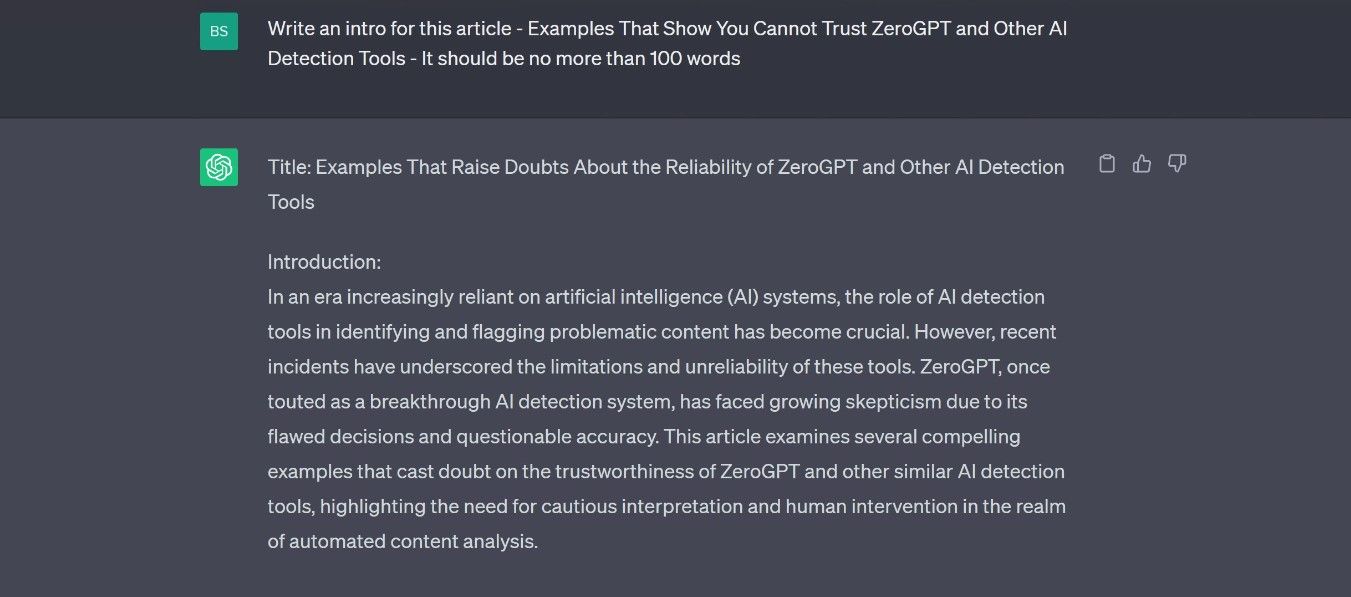

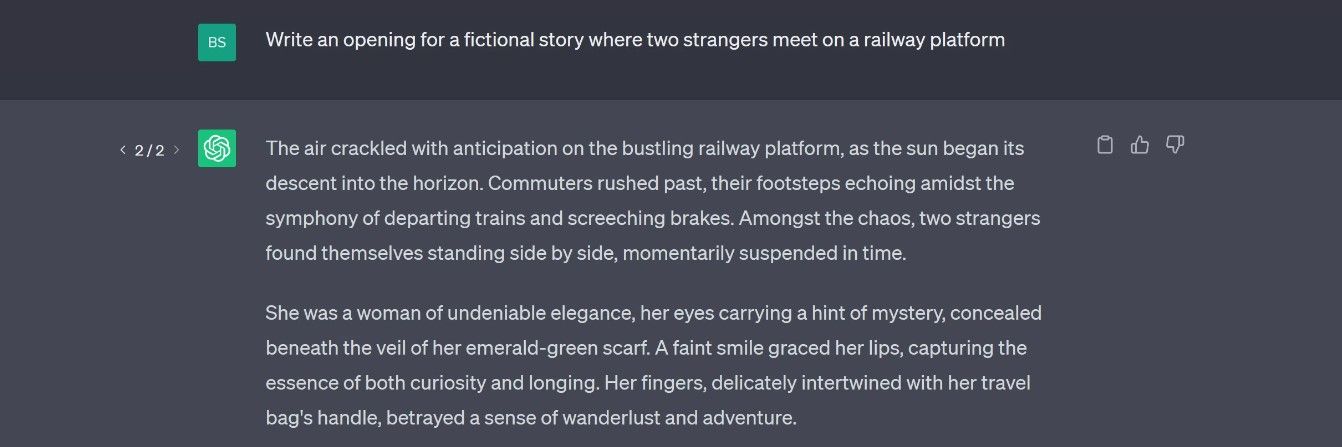

我们做的第一件事是让 ChatGPT 生成介绍。我们输入了标题,但没有提供更多信息。作为记录,我们使用 GPT-3.5 进行测试。

然后我们复制文本并将其粘贴到 ZeroGPT 中。正如您所看到的,结果并不理想。

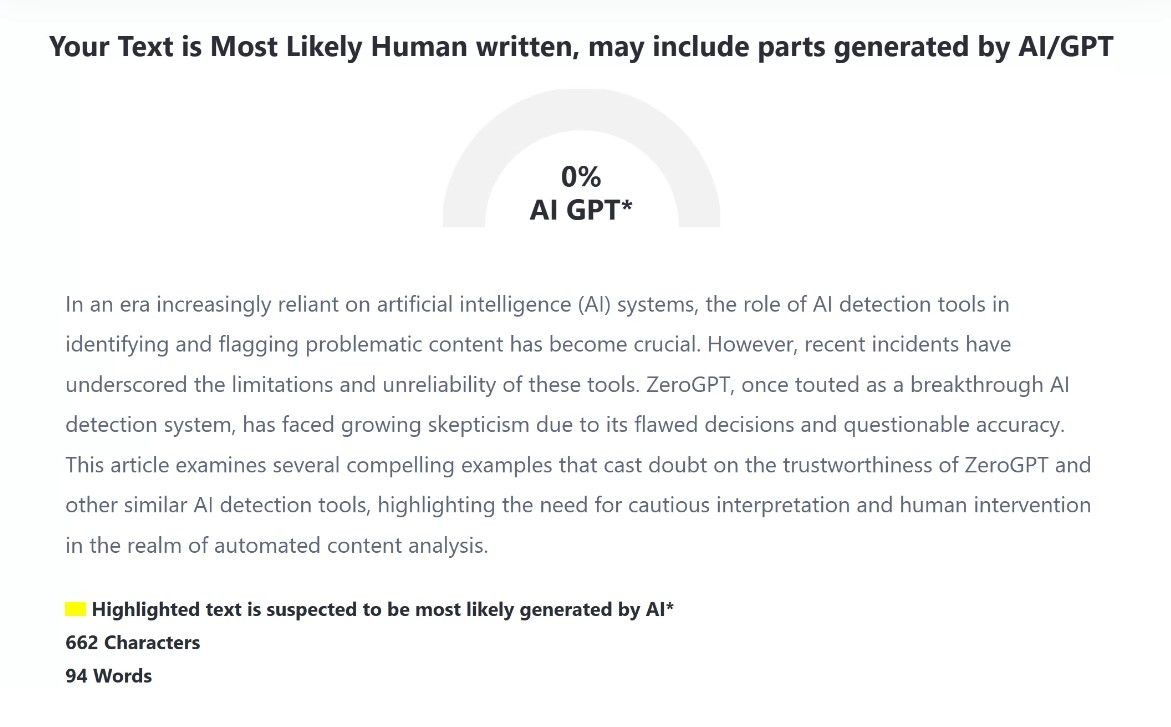

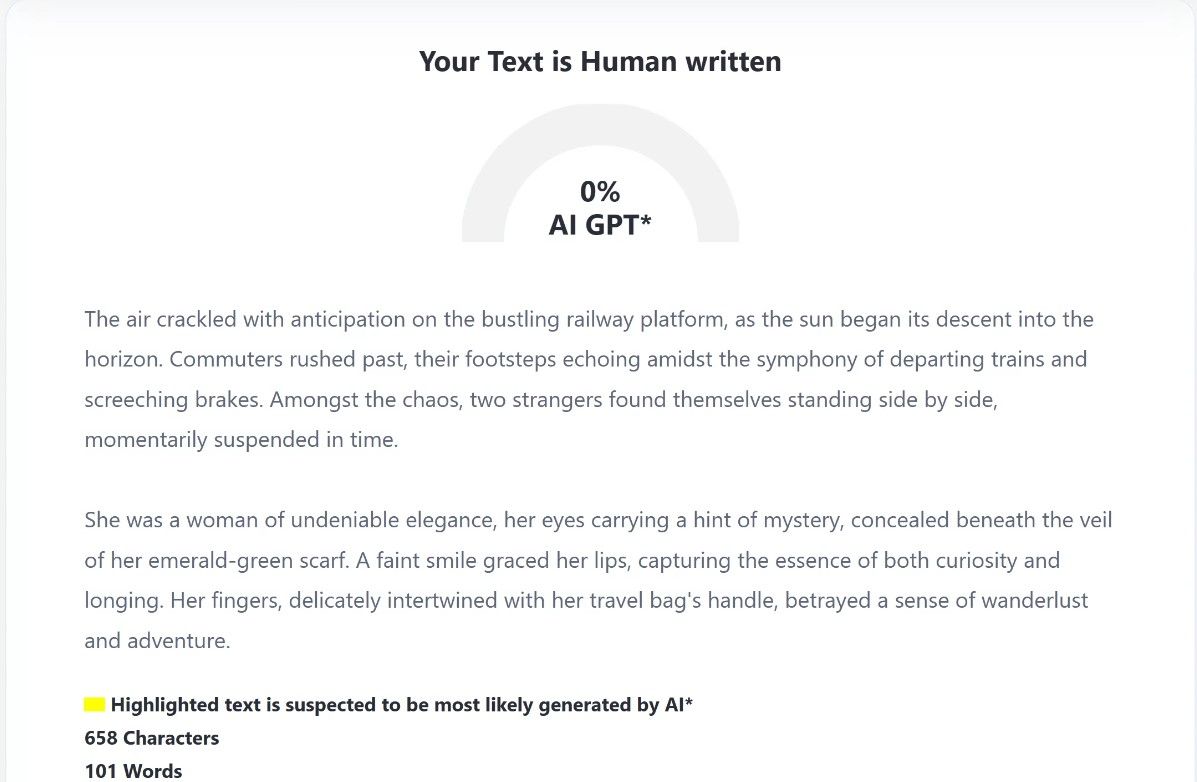

这是一个不起眼的开始,但它确实说明了人工智能聊天机器人的有效性。为了完成测试,我们让 ZeroGPT 分析人工创建的介绍草稿。

至少这部分是正确的。总体而言,ZeroGPT 在这一轮中失败了。它确实确定人工智能生成的介绍中至少有一部分是可疑的,但未能突出具体问题。

测试二:误报问题

随着 ChatGPT 和其他人工智能工具的使用不断增加,了解或听说某人声称其工作是由人工智能生成的可能性也随之增加。这些指控是 ChatGPT 和 ZeroGPT 等人工智能检测工具更严重的问题之一,因为这种错误可能会损害声誉并影响生计。

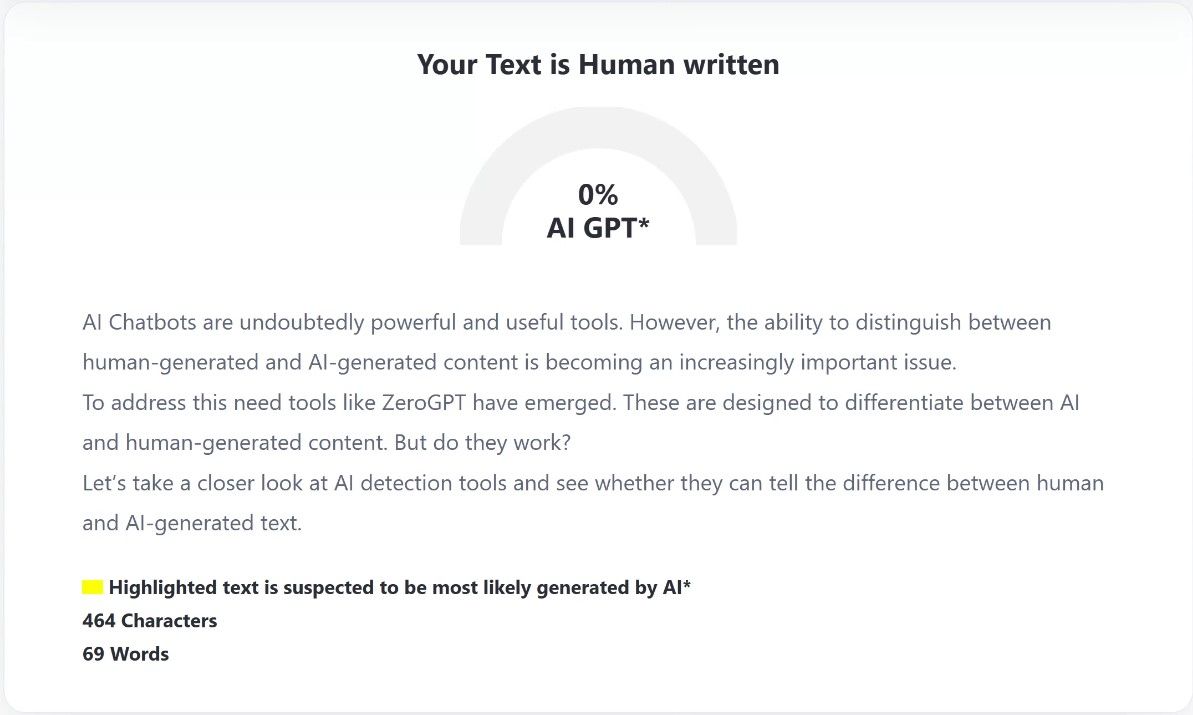

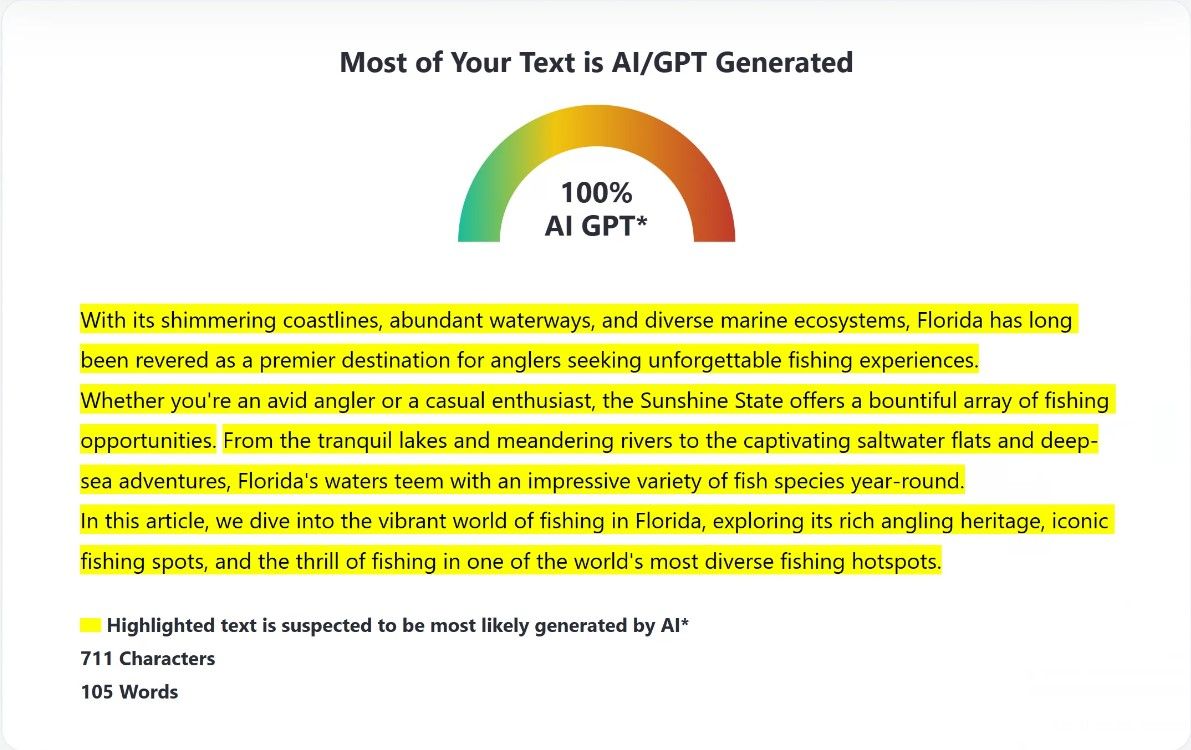

当人类生成的内容被错误地标记为人工智能的作品时,就会出现误报。如下例所示,该问题很容易复制。我是一个热衷于钓鱼的人,所以我决定写一篇关于在佛罗里达州钓鱼的虚构文章的介绍。然后,我让 ZeroGPT 分析该文本,它标记该文本 100% 由 AI 生成。

公平地说,我的目标就是这个结果。我保持文本通用并使用“销售”语言。但人类写下这篇文章的观点仍然同样有效。这并不是一种不便,也不是可以忽视的事情。此类错误可能会对作家、学生和其他创作书面作品的专业人士产生严重影响。

测试三:测试小说上的 ZeroGPT

对于第三个测试,我们将使用 ChatGPT 并要求它写一些小说。为此,我们创建了一个场景,并提示 ChatGPT 编写一个虚构故事的简短介绍。

我们保持简单,只是要求为两个陌生人在火车站台相遇的故事写一个简介:

以下是 ZeroGPT 的回应:

从结果可以看出,ZeroGPT 在处理虚构时无法区分事实和虚构!

测试四:新闻文章

人工智能能够告诉我们周围世界正在发生的事情,这令人感到不安。这并不总是“假新闻”,因为它可能是相关的和信息丰富的,但人工智能确实存在道德问题。

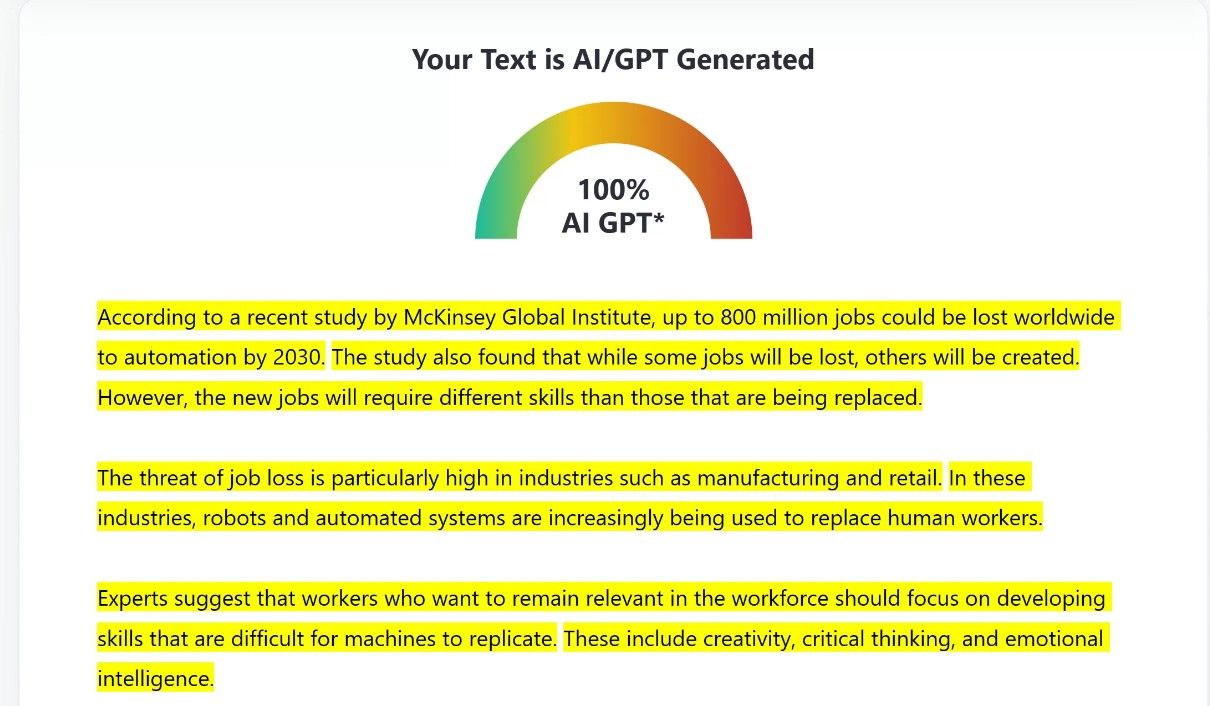

公平地说,ZeroGPT 在这次测试中表现良好。我们要求 ChatGPT 和 Bing Chat 撰写有关多个主题的新闻文章,ZeroGPT 每次都能成功。下面的示例显示它正确地将 Bing Chat 生成的文章声明为 100% AI 生成。

该工具始终将每篇新闻文章标记为人工智能生成,因此我们决定在为此目的编写的虚拟新闻文章上对其进行测试。

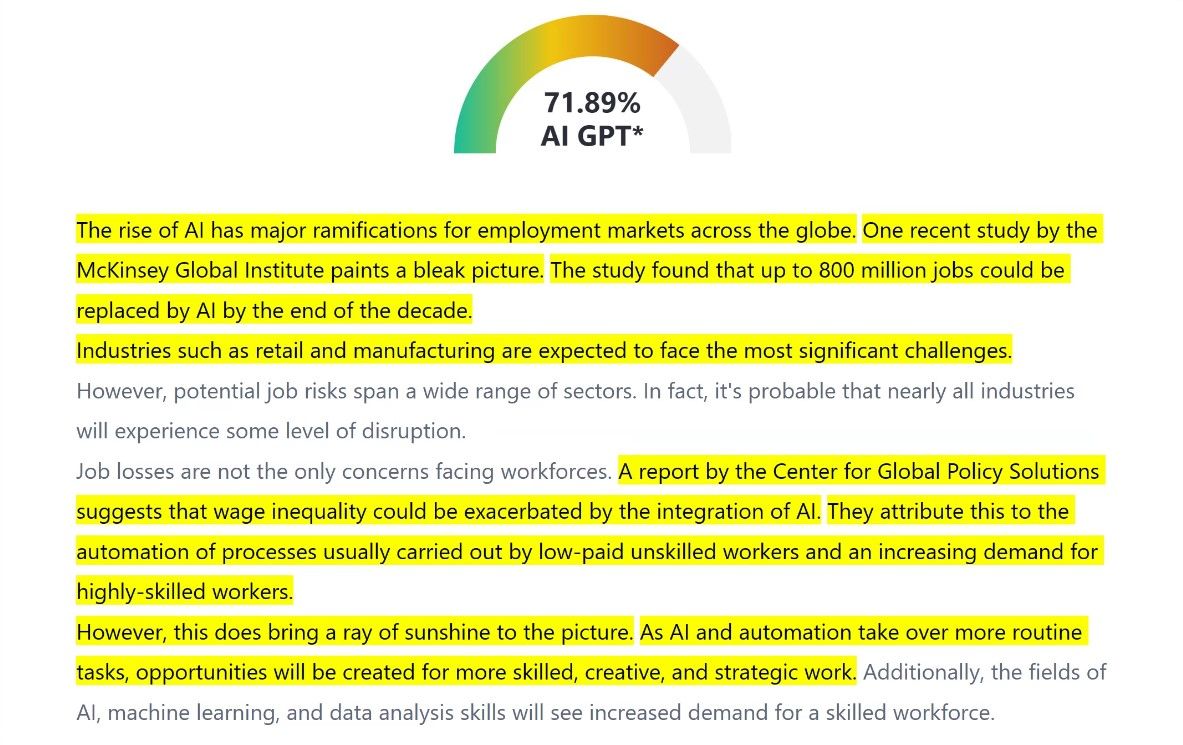

它至少确定了一些文章是人类生成的,但它标记了超过 70% 的文章是人工智能生成的。再次强调,我们在这里需要公平;这是对 Bing 文章的相当基本的重新哈希,很难达到普利策奖的质量。

但这一点仍然有效。这是由人类利用互联网上的研究成果编写的。

为什么人工智能检测工具不是很好?

ZeroGPT 等工具的缺陷背后并没有单一的原因。然而,一个根本问题是生成式人工智能聊天机器人的有效性。这些代表了一种极其强大且快速发展的技术,有效地使它们成为人工智能检测工具的移动目标。

人工智能聊天机器人不断提高其输出的质量和“人性化”,这使得这项任务极具挑战性。然而,无论困难如何,人工智能方面都必须在没有人类监督的情况下做出判断。

ZeroGPT 等工具使用人工智能来做出决定。但人工智能不仅仅在早上醒来就知道该做什么。它必须经过训练,这就是等式的技术方面变得相关的地方。

考虑到这些工具所训练的大型语言模型的庞大规模,算法和训练数据的偏差是不可避免的。这不仅仅是人工智能检测工具的问题,同样的偏见也会导致人工智能聊天机器人产生错误的反应和人工智能幻觉。

然而,这些错误在检测工具中表现为不正确的“AI 标志”。这并不理想,但它反映了人工智能技术的现状。训练数据固有的偏差可能会导致误报或漏报。

另一个必须考虑的因素是人工智能生成内容的构成。如果人工智能生成的内容只是简单地改写,那么它是人类生成的内容还是人工智能生成的内容?这代表了另一个重大挑战——两者之间的界限变得模糊,使得定义机器创建的内容几乎不可能。

展望人工智能检测的未来

这听起来像是我们正在敲打像 ZeroGPT 这样的工具。事实并非如此;他们面临着巨大的挑战,而这项技术还仅仅局限于尿布。 ChatGPT 等工具的快速普及创造了对人工智能检测的需求,应该给该技术一个成熟和学习的机会。

不能指望这些工具能够独自应对聊天机器人带来的挑战。但他们可以在协调一致、多方面的努力中发挥重要作用,以应对人工智能的挑战。它们代表了一个更大的难题的一部分,其中包括道德人工智能实践、人类监督以及持续的研究和开发。

这些工具面临的挑战是我们在应对新技术时代的困境时社会所面临的挑战的镜像。

人工智能还是非人工智能?就是那个问题

像 ZeroGPT 这样的工具是有缺陷的,这是毫无疑问的。但它们并非一文不值,它们代表了我们尝试管理和监管人工智能的重要一步。它们的准确性将会提高,但它们所接受的检测训练的人工智能的复杂程度也会提高。在这场军备竞赛中,我们需要找到一种社会能够接受的平衡。

问题是——人工智能还是非人工智能?不仅仅是讨论某些东西是否是人工智能生成的。它表明,当我们适应人工智能的美丽新世界时,社会面临着更大的问题。

根据 ZeroGPT 的记录,这一结论的 27.21% 是人工智能生成的。唔。