AI绘画,从去年4月份开始,发展的卡点一直是出图的随机性与不可控性。

去年8月底开始,Stable diffusion模型开源了,之后经过6 个月的沉淀,现在市场上各种模型层出不穷,在技术上达到了一个可怕的数量级。

Stable Diffusion是一个文本到图像的潜在扩散模型,由CompVis、Stability A和LAION的研究人员和工程师创建。它使用来自LAION-5B数据库子集的512x512图像进行训练。使用这个模型,可以生成包括人脸在内的任何图像,因为有开源的预训练模型,所以我们也可以在自己的机器上运行它。

在Stability AI的计算资源和 LAION 数据资源支持下,在LAION-5B的一个子集上训练了一个Latent Difusion Models,该模型专门用于文图生成。

主要任务场景: 无条件图片生成 (unconditional-image ) 、类别条件图片生成 (unconditional-image )、文图生成(text-to-image) 、布局图片生成 (layout-to-image) 、超分辨率 (super-resolution) 、图片修复(inpainting, object removal) 、风景图语义合成 (semantic-to-image, semantic synthesis of landscapeimages)

这些模型都是基于一套算法和某个数据集训练出来,在某个特定状态可以生成checkpoint(.ckpt文件),包含了不同的模型参数权重,对应不同的图片生成效果。

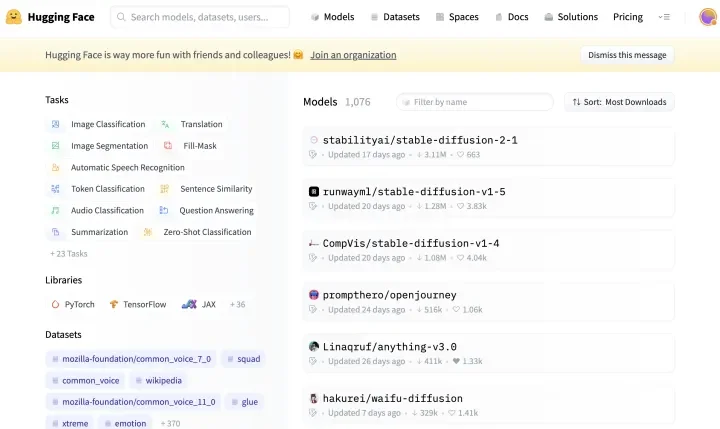

模型训练作者在训练完模型、测试效果后,通常会将模型上传到HuggingFace网站的 Stable Diffusion模型分区。

Huggingface TI分区

https:// cyberes.github.io/stabl e-diffusion-textual-inversion-models/

目前比较火的模型,通过 Stable Diffusion模型 延伸出来的,有这么几个。

Chilloutmix 模型、NovelAI 模型、LORA 模型、ControlNet