GPT4ALL是什么?

ChatGPT以及GPT-4的出现将使AI应用进入API的时代,由于大模型极高的参数量,个人和小型企业不再可能自行部署完整的类GPT大模型。但同时,也有些团队在研究如何将这些大模型进行小型化,通过牺牲一些精度来让其可以在本地部署。

GPT4ALL(GPT for ALL)即是将大模型小型化做到极致的工具,该模型运行于计算机CPU上,无需互联网连接,也不会向外部服务器发送任何聊天数据(除非选择允许将您的聊天数据用于改进未来的GPT4All模型)。它可以让你与一个大型语言模型(LLM)进行交流,获得答案、见解和建议。

GPT4All Chat适用于Windows、Linux和macOS操作系统,支持。由于该模型在本地运行,所以它不会像ChatGPT官方模型那么强大,但具备本地部署和运行的能力。

来看看GPT4ALL的实际运行效果:

ChatGPT的不开源

OpenAI作为AI领域的巨头被赞誉为一个对AI技术推动做出了巨大贡献的公司,但它遭到不少人的批评,认为OpenAI太过封闭,模型不够开放,特别是ChatGPT和GPT-4的技术细节不再透露。因此,越来越多的研究者和爱好者开始推崇开源的大模型项目。

最近Meta的LLaMA项目在GitHub上发布,号称可以比GPT-3性能更好。尽管在严格意义上不属于开源范畴,但在注册后仍然可以获取模型权重参数。这种开放性显然有助于LLaMA的发展,社区很快就为它打造出了各种扩展版本,例如C/C++版本的llama.cpp和Stanford研究员扩展的Alpaca(支持指令跟踪)。

因此,GPT4AII基于LLaMA的开源大模型框架,通过调用ChatGPT来达到类似效果,并将其小型化到使用CPU即可部署。

GPT4AII如何实现ChatGPT?

那么,我们现在进入正题,介绍GPT4AII的运行原理。相信很多人想知道一个问题:既然ChatGPT不开源,那如何来构建一个小型化的ChatGPT呢?

在GPT4AII项目中,开发团队采集了大量的常见问题和提示词(prompt),并将其交由ChatGPT(特指GPT-3.5-Turbo)生成了超过80万个高质量的提示-回答对。接下来,数据通过筛选、模型训练等步骤,确保其涵盖了各种话题和领域,并且移除了不具备多样性的回答,以使得模型表现出更好的性能。

值得一提的是,GPT4AII开发者还发布了一个经过量化后的4位版本,这意味着在普通电脑上就可以运行该模型,而不需要像部署ChatGPT那样需要海量的高性能GPU。

无独有偶,类似于GPT4ALL,最近不少社区也在尝试推动低精度计算的发展,通过降低可忽略不计的精度来使得网络所需的参数量和显存占用指数级下降。

怎样在自己的电脑上运行GPT4ALL?

接下来我们就来介绍一下如何在自己的电脑上运行GPT4ALL。步骤非常简单,GPT4ALL已经将其打包成了一键的安装包,在GPT4ALL项目的官网即可下载安装,支持Windows、Linux和macOS系统。

GPT4ALL官网:https://gpt4all.io/index.html

下载后,运行安装程序,并注意安装路径。在安装完成后,在安装路径下定位“bin”子目录,之后执行“chat”文件即可。该文件在Linux上命名为“chat”,在Windows上命名为“chat.exe”,在macOS上命名为“chat.app”。

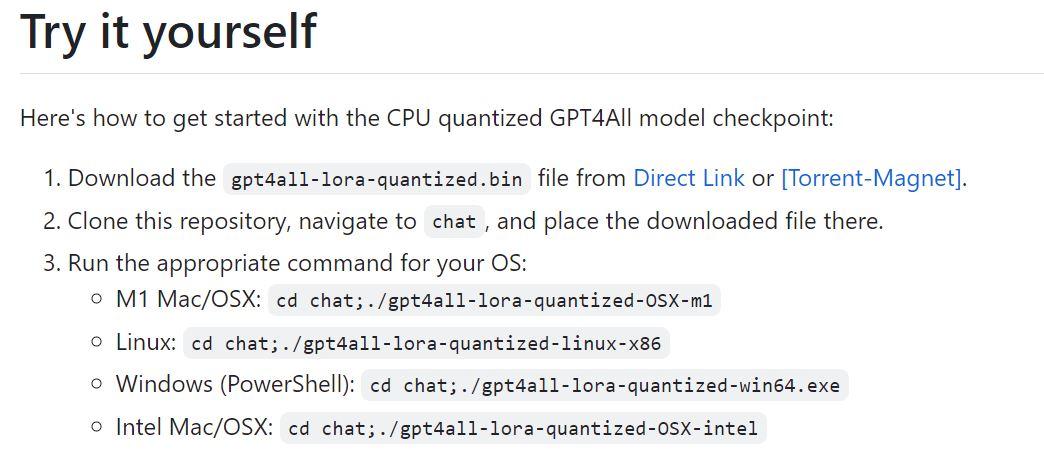

当然,也可以按照GitHub仓库中“Try it yourself”下给出的指南进行安装。

Github链接:https://github.com/nomic-ai/gpt4all

开源模型和小型化的意义和价值

GPT4AII目前在Github上已经获得了34.2k的star,这表明,开源项目和社区贡献是推动技术极为有效的方式。从商业角度来看,这也给像ChatGPT这样的闭源模型提出了不小的挑战。

毕竟,如果提供的AI服务越高效、越受欢迎,也就越容易被同行开发者和研究者模仿。对于GPT4AII来说,他们只花费了4天时间、$800的GPU成本以及$500的OpenAI API调用成本之后,就成功模仿了ChatGPT,实现了这个项目。这也引发了一个有趣的问题:闭源模型的商业模式是否可行?是否应该更积极地推进AI技术的开源和共享?

欢迎关注我的个人公众号【THU智能魔术师】