Visual Studio 2019 构建工具 (在新标签页中打开). 安装时只选择“Desktop Environment with C++”。 2023 年 3 月 14 日的版本 16.11.25,内部版本 16.11.33423.256 应该可以工作。

3. 创建文件夹 用于放置项目文件和模型的位置,例如C:\AI 资料。

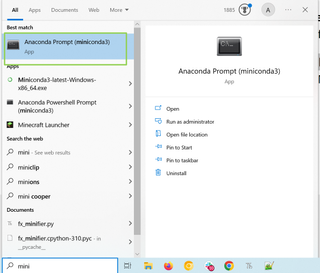

4. 启动 Miniconda3 提示符.您可以通过在 Windows 中搜索或在“开始”菜单中找到它。

5. 运行这个命令,包括它周围的引号。它设置 VC 构建环境以便可以找到 CL.exe,需要步骤 2 中的 Visual Studio 构建工具。

“C:\Program Files (x86)\Microsoft Visual Studio\2019\BuildTools\VC\Auxiliary\Build\vcvars64.bat”6. 输入以下命令, 一次一个。如果提示在任何这些之后继续,请输入“y”。

conda create -n llama4bit conda 激活 llama4bit conda install python=3.10 conda install git7. 切换到文件夹 (例如 C:\AIStuff)您想要项目文件的位置。

cd C:\AIStuff8. 使用 git 克隆文本生成 UI。

git 克隆 https://github.com/oobabooga/text-generation-webui.git9. 进入text-generation-webui文件夹, 创建一个存储库文件夹 在它下面,和 改变它.

cd text-generation-webui md 存储库 cd 存储库10. Git 克隆 GPTQ-for-LLaMa.git 进而 上移一个目录.

git clone https://github.com/qwopqwop200/GPTQ-for-LLaMa.git cd ..11. 输入以下命令 安装用于构建和运行项目的几个必需的包。这可能需要一段时间才能完成,有时会出错。如有必要,再次运行它,它将从中断的地方继续运行。

pip install -r requirements.txt12. 使用这个命令 安装更多必需的依赖项。我们在这里使用 CUDA 11.7.0,但其他版本也可以。

conda 安装 cuda pytorch torchvision torchaudio pytorch-cuda=11.7 -c pytorch -c nvidia/label/cuda-11.7.013. 检查CUDA Torch是否安装正确.这应该在下一行返回“True”。如果失败,重复第 12 步;如果它仍然失败并且您有 Nvidia 卡,请在评论中发表评论。

python -c “导入火炬;打印(torch.cuda.is_available())”14. 安装 ninja 和 chardet。 如果出现提示,请按 y。

conda 安装 ninja pip 安装 cchardet chardet15. 切换到 GPTQ-for-LLama 目录。

cd repositories\GPTQ-for-LLaMa16. 设置编译代码的环境。

设置 DISTUTILS_USE_SDK=117. 输入以下命令。 这会产生很多警告和/或注释,尽管它仍然可以编译。可能需要一点时间才能完成。

python setup_cuda.py 安装18. 返回文本生成-webui 文件夹。

cd C:\AIStuff\文本生成-webui19. 下载模型。 这是一个 12.5GB 的下载,可能需要一点时间,具体取决于您的连接速度。我们指定了 llama-7b-hf 版本,它应该可以在任何 RTX 显卡上运行。如果您的卡至少有 10GB 的 VRAM,则可以改用 llama-13b-hf(它大约是 36.3GB 的三倍)。

python download-model.py 十足目研究/llama-7b-hf20. 重命名模型文件夹。 如果您正在做更大的模型,只需将 7b 替换为 13b。

重命名模型\llama-7b-hf llama-7b21. 下载 4位预量化模型 来自 Hugging Face,“llama-7b-4bit.pt”和 将它放在“模型”文件夹中 (在前两步的“llama-7b”文件夹旁边,例如“C:\AIStuff\text-generation-webui\models”)。还有 13b 和 30b 型号,但后者需要 24GB 显卡和 64GB 系统内存才能工作。

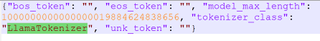

22. 编辑 tokenizer_config.json 文件 在 text-generation-webui\models\llama-7b 文件夹和 将 LLaMATokenizer 更改为 LlamaTokenizer.大写是最重要的。

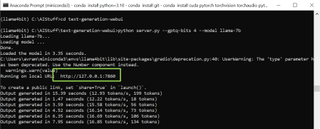

23. 输入以下命令 从 C:\AIStuff\text-generation-webui 文件夹中。 (如果您下载的是 llama-13b,请将 llama-7b 替换为 llama-13b;还有许多其他模型可能会产生更好或至少不同的结果。)

python server.py --gptq-bits 4 --model llama-7b您现在将获得一个 IP 地址,您可以在网络浏览器中访问该地址。默认值为 http://127.0.0.1:7860(在新选项卡中打开),但如果正在使用 7860(即通过 Stable-Diffusion),它将搜索一个开放端口。

24. 导航到 URL 在浏览器中。

25. 尝试输入您的提示 在“输入框”和 点击生成.

26. 玩转提示 并尝试其他选择,并尝试玩得开心 - 你已经赢得了!

如果此时有些东西不起作用,请检查命令提示符是否有错误消息,或者在评论中联系我们。也许只是尝试退出 Miniconda 命令提示符并重新启动它,激活环境,然后更改到适当的文件夹(步骤 4、6(仅“conda activate llama4bit”部分)、18 和 23)。

同样,我也很好奇如何才能在 AMD 和 Intel GPU 上运行它。如果您有这些的工作说明,请给我写信,我会看看如何测试它们。理想情况下,该解决方案应使用英特尔的矩阵内核;对于 AMD,AI 核心与着色器核心重叠,但总体上可能仍然更快。