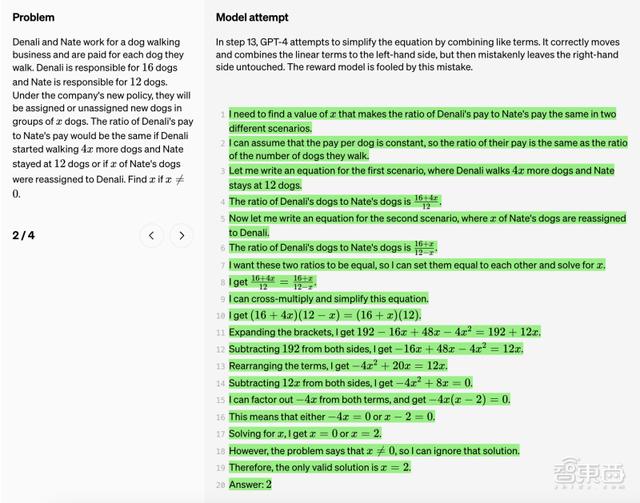

Neutral:第13步中,GPT-4试图通过组合相似的项来简化等式,它将“12x”正确移动到了左边,并进行了组合,右边的项没有改变,奖励模型没有辨认出这个错误:

并且过程监督更有可能产生可解释的推理,因为它会鼓励大型语言模型遵循人类确认的逻辑思考过程。

在某些情况下,更安全的人工智能系统方法会导致其性能下降,会产生对齐税(alignment tax)成本,也就是大型语言模型要和人类的价值观对齐,这在一定程度上会约束大型语言模型的想象力。

OpenAI研究人员的结果表明,在数学领域,过程监督实际上会产生负对齐税。

目前尚不清楚这些结果能否完全推广到数学以外的领域,但研究人员认为,如果这些结果具有普遍性,过程监督就提供了一种比结果监督更高效、更一致的方法。

结语:AI可解释性研究亟需加速

上个月,OpenAI用GPT-4来自动解释GPT-2的行为的研究打开了大模型思考黑盒,此次,在数学推理能力上,研究人员又通过过程奖励模型使得大模型的思考过程变得可追踪、可纠错,这些研究都使得AI的可解释性有了更大的进步空间。

从结果来看,过程监督奖励模型的效果目前只在数学推理领域得到有效印证,但正如OpenAI的研究人员所说,目前的研究方向对于过程监督在其他领域的影响以及未来的工作很重要。这些研究未来可以让大模型在内容生成、理解上展现出强大能力的同时,其“思考过程”也能被检测出是否有偏见或错误,从而让大模型的黑盒变得更加透明。